Uno studio condotto dal Consiglio nazionale delle ricerche e dall’Istituto Italiano di Tecnologia ha portato allo sviluppo di una nuova architettura neuromorfica che, accelerando sia l’addestramento che il funzionamento dei classificatori della rete neurale, riduce significativamente il consumo energetico. I risultati del lavoro, un approccio pionieristico che apre allo sviluppo di piattaforme innovative di memoria fotonica, sono stati pubblicati sulla rivista Nature Communications

L’intelligenza artificiale (AI) e il deep learning –o “apprendimento profondo”, una tecnica che utilizza algoritmi progettati per funzionare in modo simile al cervello umano, richiedono nella fase di addestramento intensivo delle risorse una considerevole potenza di calcolo e dati, spesso consumando energia equivalente a quella di una piccola città.

Un team di ricercatori dell’Istituto di nanotecnologia del Consiglio nazionale delle ricerche di Roma (Cnr-Nanotec) e del Center for Life Nano & Neuro-Science dell’Istituto Italiano di Tecnologia (IIT) di Roma ha introdotto una nuova architettura neuromorfica che mostra notevoli progressi, accelerando sia l’addestramento che il funzionamento dei classificatori della rete neurale, riducendo significativamente il consumo energetico. Il risultato dello studio è pubblicato di recente sulla rivista Nature Communications.

“L’hardware neuromorfico, ossia ispirato al cervello umano, presenta un’architettura informatica rivoluzionaria in grado di migliorare sostanzialmente le prestazioni e l’efficienza energetica nell’addestramento dell’AI rispetto alle generazioni precedenti. Le architetture fotoniche – ovvero i circuiti basati sulla luce invece che sull’elettronica – offrono, in aggiunta, una promettente via per accelerare ulteriormente i processi di addestramento garantendo operazioni velocissime” spiega Marco Leonetti ricercatore del Cnr-Nanotec e ideatore dello studio.

Gli autori del lavoro hanno introdotto un paradigma che trae ispirazione dal concetto di archiviazione di memoria emergente del cervello umano. Tale paradigma funziona in modo analogo al nostro sistema sensoriale che incontra molteplici rappresentazioni di oggetti appartenenti alla stessa classe (per esempio, molteplici “bicchieri” di forme, colori, e materiali diversi) e, con un processo di mediazione, amalgama i diversi esempi realizzando l’archetipo associato alla classe (l’elemento di memoria “bicchiere”). Questo processo di generalizzazione, chiamato “archetipo emergente” ci permette di riconoscere qualsiasi “bicchiere”, indipendentemente dalla specifica foggia con cui si presenti.

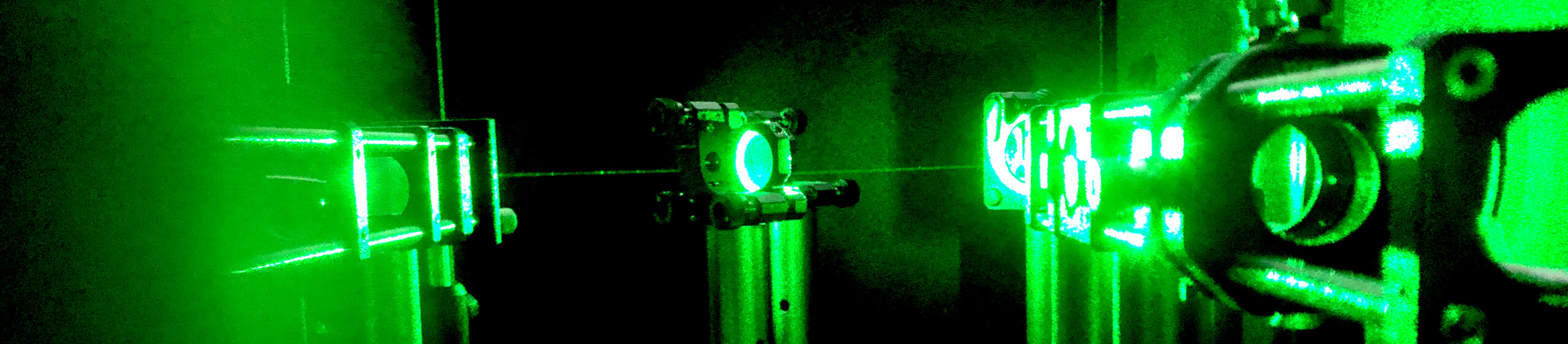

“Dal processo di mediazione emerge un elemento di memoria quasi privo di imperfezioni che rappresenta la classe”, aggiunge Giancarlo Ruocco ricercatore al Center for Life Nano- & Neuro-Science dell’Istituto Italiano di Tecnologia di Roma nonché professore ordinario all’Università La Sapienza e co-autore dello studio. “Analogamente”, conclude Giancarlo Ruocco, “nella conduzione dello studio, abbiamo utilizzato delle strutture luminose casuali, generate tramite un laser e un mezzo auto-assemblato simile ad una goccia di vernice bianca, che richiedono un processo di fabbricazione estremamente semplice ed economico. La memoria emergente risulta dalla somma delle intensità luminose prodotte dalle numerose strutture luminose imperfette generate dal mezzo dispersivo. In tale processo additivo, le singole differenti imperfezioni vengono “mediate” generando un singolo pattern privo di errori”.

L’approccio pionieristico che caratterizza lo studio apre allo sviluppo di piattaforme innovative di memoria fotonica ossia memorie in cui si immagazzinano proprietà ottiche invece che elettroniche e che quindi hanno un intrinseco vantaggio dal punto di vista della velocità. L’apprendimento emergente ha pertanto il potenziale per inaugurare una nuova era di apprendimento automatico con costi computazionali, economici ed energetici, significativamente ridotti sia fase di addestramento che di utilizzo.

Roma, 30 gennaio 2024